技術的、法的、倫理的な

リスクの管理も重要

先に奥野氏が触れたように、AI活用にはリスクが伴う。AIの学習データに個人情報や機密情報、特定顧客の取り扱い注意情報などが含まれているかもしれない。その場合、外部には見せられない情報が出力される可能性がある。

「AIが収益拡大などにも活用されるようになれば、個人情報や機密情報などを扱う機会が増え、いっそうの注意が必要です。また、海外展開している企業の場合、サイバーセキュリティやプライバシーに関する各国・地域の法規制への対応が必須。特にプライバシーデータの越境には、法規制上の問題がないか厳しくチェックする必要があります」と、PwCコンサルティング上席執行役員パートナーの林和洋氏は言う。

上席執行役員 パートナー

トラストコンサルティング

林 和洋氏

情報を扱ううえでのリスクは以前からあったが、AI特有のリスクも考慮しなければならない。林氏が続ける。

「技術的、法的なリスクに加えて、AIには倫理的なリスクもあります。学習データ次第で、差別などにつながりかねない偏見やバイアスが入ってしまう可能性がある。また、従来の情報セキュリティ施策は、IT部門などが主導して施策を現場に落とし込むというアプローチが一般的でした。これに対して、AI活用は現場主導で進むので、より実践的なリスク管理のルールや手法を考える必要があるでしょう」

AIガバナンスの強化に向けては、各国の政府機関などが提示するガイドラインを踏まえたうえで、リスクに応じた管理手法を検討する必要がある。たとえば、AIを搭載した自社開発の法人営業支援アプリ。そのリスクをどのように評価すべきか。

「当社が推奨しているのは、『AIレッドチーム』による検証です。ハッカーと同じ視点で、疑似的な攻撃を実施してリスクを調査する。単にセキュリティの“穴”を調べるだけでなく、AI搭載アプリの有効性を、倫理的な観点を含めて評価します」(林氏)

生成AIが急速に普及し始めた2022年以降、AI関連のインシデントも急増している。情報の窃取などの被害だけでなく、機械装置の誤作動など人命に関わりうる問題も報告されているという。将来的には、自動運転やAIロボットなどが一般化する可能性も考えられる。フィジカルな世界でAI活用が広がりつつある中、こうしたリスク面にも十分注意を払う必要がある。

人とAIとの協働は一気に実現するわけではない。小高氏が提案するのは3ステップのアプローチだ。

「まず、顧客の購買体験や、付加価値増につなげるためには自社で何をすべきかを洗い出し、人とAIの協働の『あるべき姿』を描きます。第2ステップでは、トライアル・アンド・エラーを繰り返しながら、人とAIエージェントを組み合わせたユースケースをアジャイルにAIで試してみる。並行して、AI精度向上のためのデータ整備を進めます。第3ステップは、協働のためのオペレーティングモデルを見直しつつ、さらなる利活用や効果創出の加速に向けて、安全にAIを活用するための『守り』の施策を進めます」

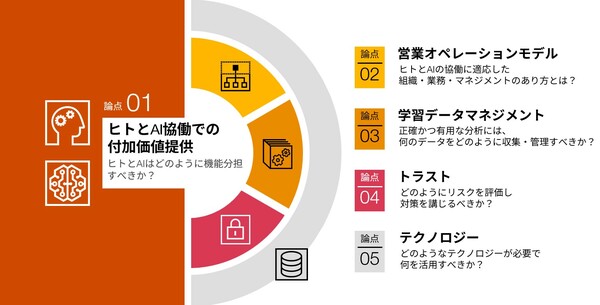

ステップ・バイ・ステップでのアプローチの途上には、さまざまなハードルが待ち受けているだろう。その道のりにPwCコンサルティングは伴走し、ビジネスと技術、リスク管理など多方面から企業をサポートしている(図表)。

図表 AIを活用した営業改革を成功させるための5つの論点

PwCコンサルティング合同会社

〒100-0004 東京都千代田区大手町1-2-1 Otemachi One タワー

URL:https://www.pwc.com/jp/

■関連リンク

生成AI活用による営業業務の効率化・高度化支援

https://www.pwc.com/jp/ja/services/consulting/customer/generative-ai-for-sales.html

生成AIに関する実態調査2024 春 米国との比較

https://www.pwc.com/jp/ja/knowledge/thoughtleadership/generative-ai-survey2024-us-comparison.html