-

Xでシェア

-

Facebookでシェア

-

LINEでシェア

-

LinkedInでシェア

-

記事をクリップ

-

記事を印刷

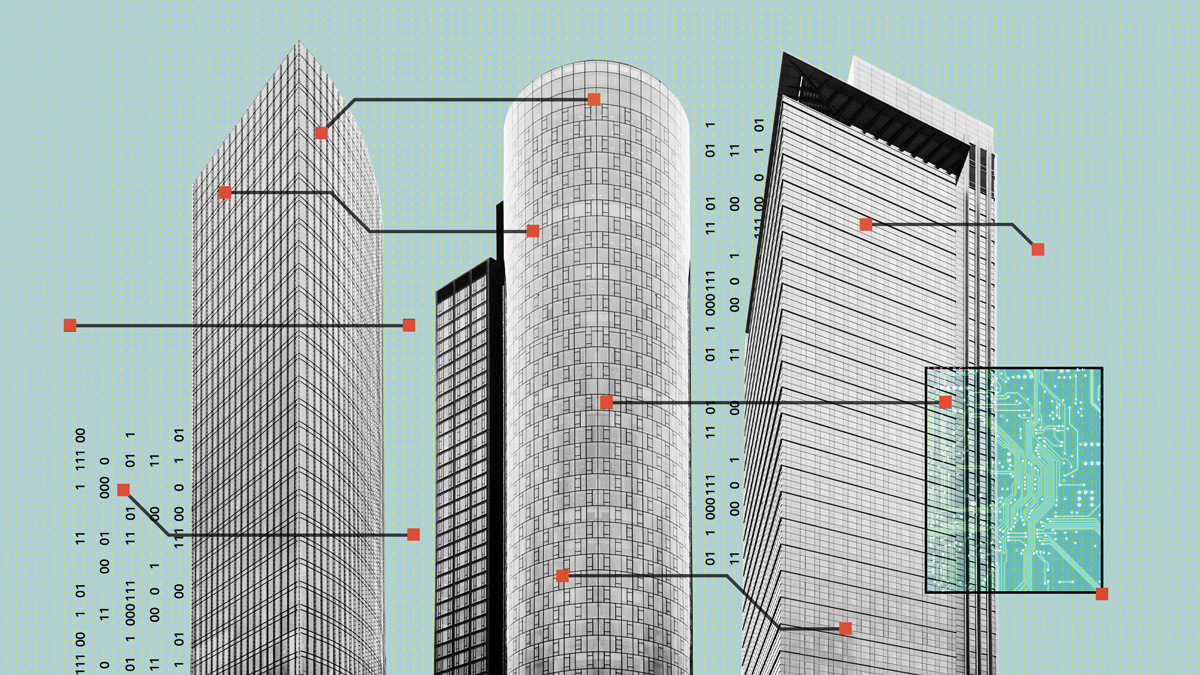

責任あるAIを組織に組み込むためにどうすべきか

2024年3月に欧州議会でAI規制法が承認された時、大手通信企業ドイツテレコムは自信を感じ、準備はできているという手応えがあった。同社は2018年に責任あるAIの原則を確立して以降、これらの原則をAIベースの製品やサービスの開発サイクルに組み込むように努めてきた。

「AIの規制が目前に迫っていることを見据えて、開発チームのオペレーションにこの原則を組み込むよう奨励し、後から混乱を伴う調整を強いられることを回避しようとしました。責任あるAIは、いまでは私たちのオペレーションの一部になっています」と、同社のグループコンプライアンス・企業倫理担当のマイケ・ショルツは説明する。

残念ながら、筆者らの研究が示唆するように、こうした事前の積極的な対策は例外的であり、一般的ではない。AI倫理は多くの組織にとって重要な課題ではあるものの、AIの原則を実践や行動に移すことは、まさに口で言うほど簡単ではないのだ。しかし、コンプライアンス違反に厳しい制裁金が科されることを考えれば、待ったなしの状態である。責任あるAIのイニシアティブを強化するために、リーダーは何をすべきだろうか。

筆者らは、その答えを見つけるために多様な業界の組織を訪ねたところ、責任あるAIの導入に向けて、さまざまな段階があることを知った。データエンジニアやデータサイエンティストは通常、構想から生産に至るまでAIの開発ライフサイクルの大部分の責任を担うが、非技術系のリーダーは、責任あるAIの統合を確実に行うために重要な役割を果たすことができる。筆者らは、責任あるAIの実践を、より広範な業務上の基準に完全に統合させるために、リーダーが取るべき4つの重要な行動──翻訳、統合、調整、普及──を特定した。

第1段階:ハイレベルな原則を実践的なガイダンスに翻訳する

多くの組織がAI倫理憲章を策定しているが、AIの原則を日常業務に導入する際に苦労することが少なくない。技術系労働者の79%が、倫理的な問題を解決するための実用的なリソースが必要だと回答しており、これらの原則を実用的なガイダンスに翻訳する必要がある。

![H.ミンツバーグ経営論[増補版]](https://dhbr2.ismcdn.jp/mwimgs/8/7/135w/img_871cd4da49e5d4f957c01d18842ab79034921.jpg)